서울대·KAIST 연구팀 "의도예측 머신러닝 기술 개발"

(서울=연합뉴스) 이주영 기자 = 국내 연구진이 척수손상(SCI) 등으로 손을 못 움직이는 사람의 의도를 예측, 물건을 잡고 옮기는 등 원하는 동작을 할 수 있게 해주는 착용형 손 로봇(wearable hand robot) 시스템을 개발했다.

인간중심 소프트 로봇기술 연구센터(SRRC) 조규진 서울대 교수팀과 조성호 KAIST 교수팀은 31일 국제학술지 '사이언스 로보틱스'(Science Robotics)에서 딥러닝(deep learning)을 사용한 웨어러블 손로봇의 새로운 의도예측 방법론을 개발, 손을 못 움직이는 SCI 환자가 손로봇(Exo-Glove Poly Ⅱ)을 이용해 물건을 잡고 옮기게 하는 데 성공했다고 밝혔다.

이 시스템은 서울대 연구팀이 어깨와 팔은 움직일 수 있지만 손가락을 못 움직여 물체를 잡을 수 없는 장애인이 사용할 수 있도록 개발 중인 웨어러블 손로봇에 사용자 의도를 예측하는 기계학습 알고리듬을 통합한 것이다.

척수손상 등으로 팔다리가 마비된 환자의 움직임을 돕는 장치나 로봇은 활발히 연구되고 있으나 사용자 의도를 미리 파악해 원하는 동작을 하도록 하는 것은 아직 제대로 구현되지 못하고 있다.

이를 위해 근육의 전기신호를 이용해 사용자의 의도를 파악하는 보조로봇이 개발되기도 했으나 많은 사람에게 개인 맞춤형으로 적용하기 어려워 널리 활용하는 데에는 한계가 있다.

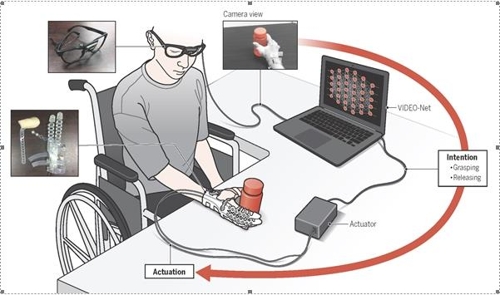

연구팀은 이 연구에서 딥러닝 알고리듬을 기반으로 사용자 눈에 보이는 장면을 그대로 촬영하는 1인칭 시야 카메라를 이용해 웨어러블 손로봇을 착용한 사람의 의도를 예측하는 방법을 개발했다.

이들은 사람이 물체를 보고 손을 사용하려 할 때의 의도를 그 사람의 팔 움직임과 손-물체의 상관관계를 통해 예측할 수 있다는 가설에 기반해 딥러닝 모델인 '비디오넷'(Video-Net)을 제안했다.

안경에 부착된 카메라를 활용해 사용자의 의도를 예측하는 비디오넷은 척수손상 환자의 손과 물체의 상관관계를 파악하는 공간 정보와 팔의 움직임을 파악하는 시간 정보로 구성된다.

머신러닝 기반 사용자 의도예측 알고리듬이 적용된 착용형 손로봇(Exo-Glove Poly 2) 시연. [인간중심 소프트 로봇기술 연구센터(SRRC)·서울대·카이스트 제공]

비디오넷을 안경처럼 쓰고 손로봇을 착용한 상태에서 물체를 향해 팔을 뻗으면 비디오넷은 팔 움직임과 손-물체 간 거리 등 정보를 종합, 사용자가 물체를 잡으려 하는 것으로 예측한다. 팔을 계속 내밀어 손이 물체에 닿으면 손로봇이 작동해 마비된 손이 물체를 잡을 수 있게 돕는다.

실제로 이 연구에서 손을 움직이지 못하는 척수손상 환자가 비디오넷과 웨어러블 손 로봇을 이용해 물건을 잡아 옮기는 데 성공했으며, 아무 도움 없이 커피를 마시는 등 일상 활동도 할 수 있었다고 연구팀은 밝혔다.

하지만 연구팀은 이 시스템은 잡으려는 물체나 손이 다른 물체로 가려지는 등 비디오넷이 팔 움직임이나 물체를 인식하기 어려운 경우에는 제대로 작동하지 않는 등 개선할 점이 많다며 아직 상용화를 말하기에는 이르다고 설명했다.

조규진 교수는 "소프트 웨어러블 로봇에 카메라를 사용해 사용자 의도를 파악하는 기술을 적용한 연구는 아직 없었다"며 "사용자 의도를 미리 파악해 로봇이 작동하게 함으로써 훨씬 자연스러운 동작 구현이 가능하다"고 말했다.

그는 또 "앞으로 카메라를 사용해 사용자 의도를 파악하는 기술들이 다른 웨어러블 로봇에도 적용되면 더 쉽고 정확하게 원하는 방식으로 웨어러블 로봇을 제어할 수 있게 될 것"이라고 덧붙였다.

scitech@yna.co.kr

(끝)

<저작권자(c) 연합뉴스, 무단 전재-재배포 금지>