네이버는 오는 27일 대화형 에이전트 클로바X에 시각 정보 처리 능력을 추가한다고 22일 발표했다. 기업 간 거래(B2B) 클라우드 솔루션 ‘클로바 스튜디오’에도 동일한 기능이 들어간다. 네이버가 개발한 HCX에 이미지 이해 능력을 더한 ‘HCX 비전’을 활용했다.

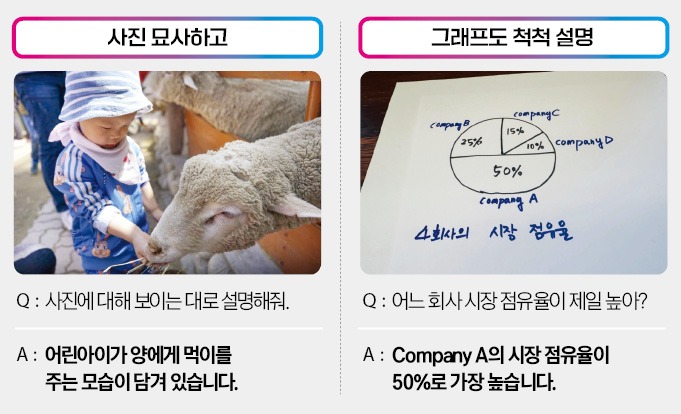

이번 업데이트로 이용자는 클로바X 대화창에 이미지를 업로드하고 여기의 정보를 바탕으로 AI와 대화할 수 있게 됐다. 클로바X는 사진 속 상황을 묘사하거나 상황을 추론하는 등 다양한 지시를 수행할 수 있다.

예를 들어 고기, 양파, 토마토, 빵 등의 사진을 올려놓고 ‘이 재료들로 만들 수 있는 음식의 레시피를 알려줘’라고 질문하면 햄버거를 제조하는 순서를 알려준다. 이미지 형태로 된 차트, 표의 내용도 이해할 수 있다. 특정 도형과 차트, 그래프 등을 생성하는 데 필요한 코드 생성도 가능하다. 회사 관계자는 “이미지 이해 능력을 기반으로 개인의 생산성 향상 도구로써 활용 범위가 한층 넓어질 것으로 기대한다”고 말했다.

네이버는 HCX 비전의 성능이 오픈AI의 기업용 AI 모델인 GPT-4v와 비슷한 수준이라고 설명했다. HCX 비전의 벤치마크 평균 점수는 71.59점으로 GPT-4v(71.63점)와 큰 차이가 없다.

한국어와 관련한 부분에선 강점이 확실하다. 초·중·고교 검정고시 총 1480개 문항을 AI 모델에 이미지 형태로 입력하고 문제를 풀게 한 결과 HCX 비전은 84%의 정답률을 기록해 오픈AI의 GPT-4o(78%)를 앞섰다.

네이버는 HCX 기반 음성 AI 기술인 ‘스피치X’도 공개했다. 기존의 음성 인식·합성 기술보다 한층 발전한 모델로 언어 구조, 발음 정확도 등이 크게 개선됐다. 사람처럼 감정도 표현할 수 있다. 네이버는 스피치X를 고도화해 개인화 음성 서비스, 실시간 음성 번역, 감정 표현 음성 합성, 대화형 AI 응답 등 다양한 분야에 적용할 계획이다.

성낙호 네이버클라우드 하이퍼스케일AI기술총괄은 “대규모언어모델(LLM)로 출발한 HCX는 이미지 이해 능력을 더한 거대 시각 언어 모델, 나아가 음성 멀티모달 언어 모델로 발전하고 있다”며 “클로바X를 비롯한 여러 네이버 서비스에 적용해 HCX 생태계를 확장할 것”이라고 말했다.

업계에서는 이번 업데이트를 긍정적으로 보고 있다. 네이버가 멀티모달 분야에서 오픈AI와 구글, 마이크로소프트 등 글로벌 빅테크와의 격차를 좁혔다는 게 업계의 중론이다. 네이버는 2021년 5월 국내 최초의 LLM인 하이퍼클로바를 공개했다. 세계에선 세 번째 기록이다. 작년 8월엔 이를 개량한 HCX를 발표하고, 챗봇 서비스 클로바X도 출시했다.

이승우 기자 leeswoo@hankyung.com