최근 SK하이닉스는 충북 청주에 고성능 D램인 고대역폭메모리(HBM) 생산라인을 증설하기로 했다. 기존 HBM 생산라인이 경기 이천에 몰려 있는 것을 감안할 때 의외의 결정이라는 평가가 나온다. 청주는 지금껏 낸드플래시 생산기지 역할을 했다.

이례적인 투자 결정이 나온 건 HBM 라인을 빠르게 증설해야 할 필요성이 커졌기 때문이다. 엔비디아 등 인공지능(AI) 반도체 고객사로부터 HBM 주문이 물밀듯 들어오는데, 이천은 라인을 늘릴 공간이 부족한 상황이다. 업계 관계자는 “HBM 수급이 전례없이 빡빡하다”고 전했다.

SK는 청주, 삼성은 천안에 투자

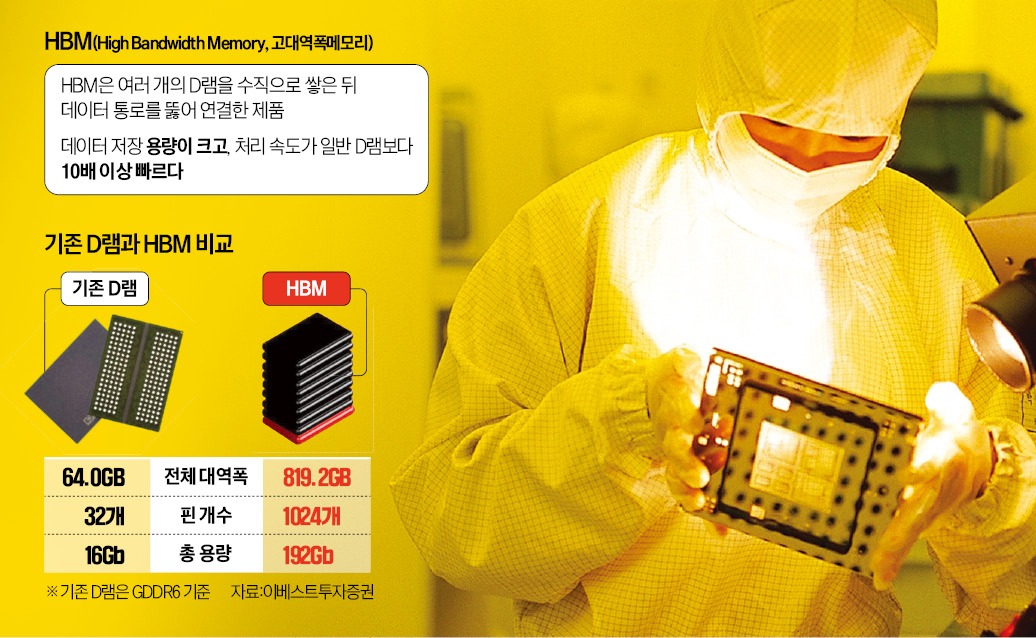

31일 반도체업계에 따르면 삼성전자와 SK하이닉스 등 국내 메모리 반도체 기업들은 HBM 전용라인 증설을 추진하고 있다. HBM은 일반 D램 대비 데이터 용량·속도를 10배 이상 높인 제품으로 ‘고성능 D램’으로도 불린다. 메모리 반도체 기업들은 생산된 D램 웨이퍼를 받아 수직으로 쌓고 칩에 구멍을 뚫어 전기신호로 연결하는 첨단패키징 공정을 거쳐 HBM을 완성한다.두 회사는 내년 말까지 총 2조원 이상의 자금을 투입해 HBM 라인의 생산능력을 현재의 2배 이상으로 끌어올릴 계획이다. SK하이닉스는 기존 HBM 생산기지인 이천에 이어 청주 공장의 여유 공간을 활용할 예정이다. 삼성전자는 디바이스솔루션(DS)부문장 직속 첨단패키징(AVP)팀이 있는 충남 천안에 HBM 핵심 라인을 증설하는 방안을 검토 중이다.

고객사와 1~2년 협의해 맞춤생산

D램 업황이 아직 회복되지 않았는데도 삼성과 SK가 조(兆) 단위 투자를 추진하는 건 HBM 수요가 빠르게 늘고 있어서다. 시장조사업체 트렌드포스에 따르면 기가바이트(GB)로 환산한 HBM 수요량은 2022년 1억8100만GB에서 2023년 2억9000만GB로 60% 급증할 것으로 전망된다. 2024년엔 2023년보다 30% 더 증가할 것으로 예상된다.수요가 가파르게 늘고 있는 건 챗GPT 같은 생성형 AI 시장이 커지고 있기 때문이다. 생성형 AI의 핵심은 대규모 데이터 학습을 통해 질문에 대한 답의 정확도를 높이는 것이다. 대규모 데이터를 동시에 빠르게 학습할 수 있는 칩으론 그래픽처리장치(GPU)가 낙점됐다. 여기에 GPU가 처리할 데이터를 저장하는 D램도 필수적이다. 일반 D램으론 GPU와 대규모 데이터를 주고받기 어렵다. 최신 HBM인 ‘HBM3’는 D램 최신 제품인 GDDR6 대비 총용량이 12배, 대역폭은 13배 정도 큰 것으로 알려졌다. 도로로 따지면 일반 D램이 1차로인 데 비해 HBM은 13차로여서 교통(데이터 흐름)이 원활한 것과 비슷한 이치다.

고객사와 HBM 제조업체들은 보통 1년 이상 제품 개발을 논의하며 ‘맞춤형 제품’을 생산한다. 최근 엔비디아가 납품받고 있는 SK하이닉스의 HBM2E, HBM3도 1~2년 전부터 공동 개발한 제품이다. 반도체업계 관계자는 “자체 생성형 AI를 개발 중인 주요 기업도 삼성과 SK에 HBM을 함께 만들자고 요청하고 있다”고 전했다.

생산비 낮추는 것은 과제

HBM은 얼어붙은 메모리 반도체 시장을 녹이고 있다. 삼성과 SK하이닉스가 정확한 HBM 가격을 밝히지 않고 있지만 4세대 최신 제품인 HBM3 가격은 최신 일반 D램의 5~6배 정도로 알려져 있다. 올해 기준 HBM 출하량이 전체 D램 출하량의 1.7% 수준임에도 매출 비중이 11%에 달할 것으로 전망되는 것도 이런 이유 때문이다.메모리 반도체 기업의 실적 개선에도 긍정적인 영향을 주고 있다. SK하이닉스는 지난 26일 열린 2분기 실적설명회에서 “D램의 2분기 평균판매가격(ASP)이 전 분기 대비 ‘한 자릿수 후반%’ 상승했다”며 “고부가가치 제품을 많이 판매한 영향”이라고 설명했다.

HBM 수율을 더 높이고 생산비용을 낮춰야 진정한 ‘캐시 카우’가 될 것이란 지적도 나온다. 한 수도권 대학의 반도체학과 교수는 “D램을 많이 쌓을수록 수율이 낮아져 비용이 증가한다”며 “수요처가 ‘생성형 AI 서버’로 제한적인 점도 극복해야 한다”고 말했다.

황정수/최예린 기자 hjs@hankyung.com