KAIST가 구글과 IBM을 뛰어넘는 초대규모 인공지능(AI) 연산모델을 개발했다고 20일 발표했다.

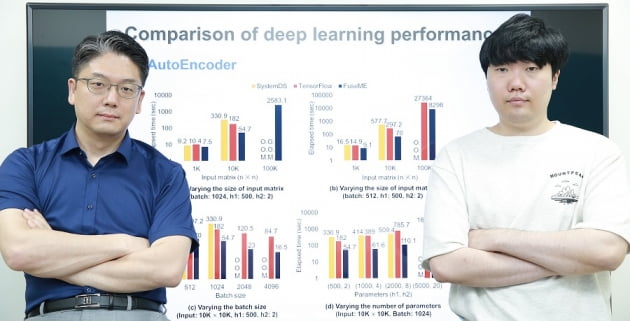

KAIST 전산학부 김민수 교수(사진 왼쪽) 연구팀은 딥러닝 등 기계학습 시스템의 성능을 대폭 높일 수 있는 행렬 연산 융합 기술, 일명 '퓨즈ME(FuseME)'를 개발했다고 이날 밝혔다.

보통 딥러닝 모델은 행렬 곱, 행렬 합 등 무수한 행렬 연산을 융합해 이뤄진다. 이를 '방향성 비순환 그래프(DAG) 질의 계획'이라고 말한다. DAG 질의 계획은 수많은 컴퓨터로 구성된 클러스터 등에서 처리된다.

그런데 모델 규모가 커지면 커질수록 처리에 실패하거나 시간이 오래 걸리는 문제가 있었다. DAG 질의 계획을 구성하는 행렬 연산의 중간 데이터가 제대로 처리되기 전에 메모리에 갑자기 저장되거나, 네트워크 통신을 통해 다른 컴퓨터로 옮겨가는 경우가 많아서다.

KAIST 관계자는 "기존 기계학습 시스템은 가장 복잡한 행렬 연산인 행렬 곱을 제외한 나머지만을 융합해 성능이 잘 개선되지 않거나, 전체 DAG 질의 계획을 단순히 하나의 연산처럼 실행하는 한계가 있었다"고 설명했다.

김 교수 연구팀은 어떤 연산끼리 융합하는 것이 AI 성능을 높일 수 있는지 비용 기반으로 판별해 그룹으로 묶는 방법을 고안했다. 그리고 각 그룹 성질과 네트워크 통신 속도, 입력 데이터 크기 등을 모두 고려해 최적 성능을 낼 수 있는 '퓨즈ME' 기술을 개발했다. 행렬 곱까지 모조리 융합해 연산을 처리하는 게 이 기술의 핵심이다.

연구팀은 "구글 텐서플로, IBM의 시스템DS와 비교 평가한 결과 딥러닝 모델 처리 속도를 최대 8.8배 높이고 이들이 처리할 수 없는 훨씬 더 큰 규모의 데이터를 처리하는 데 성공했다"고 주장했다. 또 연산 융합 속도가 기존에 비해 최대 238배 빨라지고, 네트워크 통신 비용을 64분의 1까지 감소시킬 수 있다고 덧붙였다.

연구팀은 앞서 2019년 초대규모 행렬 곱 연산이 가능한 'DistME'란 기술을 선보인 바 있다. 이번 퓨즈ME는 DistME 기술을 발전시킨 것이다.

김 교수는 "기계학습 모델 처리 규모와 성능을 획기적으로 높일 수 있어 산업적 측면에서 파급효과가 클 것으로 기대한다"고 말했다. 이번 연구성과는 지난 16일 미국 필라델피아에서 열린 데이터베이스(DB) 분야 권위있는 국제학술대회 중 하나인 'ACM SIGMOD'에서 발표됐다.

이해성 기자